La inteligencia artificial está cada vez más presente en nuestra vida diaria y en nuestro trabajo. Hoy en día no es extraño que un asistente o una asistente virtual nos recuerde una cita, que un sistema automático nos ayude a resolver un trámite administrativo o que un programa de análisis de datos apoye a un equipo médico para identificar una enfermedad. Estas herramientas son rápidas, eficientes y, a primera vista, parecen objetivas. Sin embargo, no debemos olvidar que la inteligencia artificial aprende de la información que le damos, y esa información proviene de personas y de una sociedad que arrastra desigualdades y estereotipos desde hace siglos. Esto significa que, si no tenemos cuidado, la IA puede no sólo repetir esos prejuicios, sino incluso amplificarlos.

Cuando un sistema se entrena con datos que reflejan, por ejemplo, que las mujeres cobran menos que los hombres, que están menos presentes en profesiones tecnológicas o que suelen asumir las tareas de cuidado, el resultado es un modelo que incorpora esas mismas desigualdades. Hay ejemplos claros como programas de reconocimiento facial que fallan más al identificar a mujeres, especialmente si son racializadas, porque las bases de datos que se usaron para entrenarlos incluían sobre todo imágenes de hombres blancos. También hay ejemplos de asistentes virtuales con voces femeninas y nombres de mujer por defecto, que refuerzan la idea de que el papel de ayudar y servir es “propio” de ellas o sistemas de selección de personal que descartan candidatas simplemente porque fueron entrenados con historiales laborales en los que se favorecía a hombres.

Esto ocurre por varias razones que se combinan entre sí. Una de ellas es la llamada asimetría de datos: en general hay más información recogida sobre hombres que sobre mujeres, y todavía menos sobre mujeres racializadas, con discapacidad o en situación económica vulnerable. Otra razón es que la mayoría de las personas que programan y diseñan la IA son hombres, lo que influye en qué problemas se priorizan y cómo se plantean las soluciones. Además, se usan con frecuencia datos históricos, que reflejan un pasado desigual, y si no se corrigen esos datos antes de entrenar a la IA, el sistema terminará reproduciendo las mismas injusticias en sus decisiones futuras.

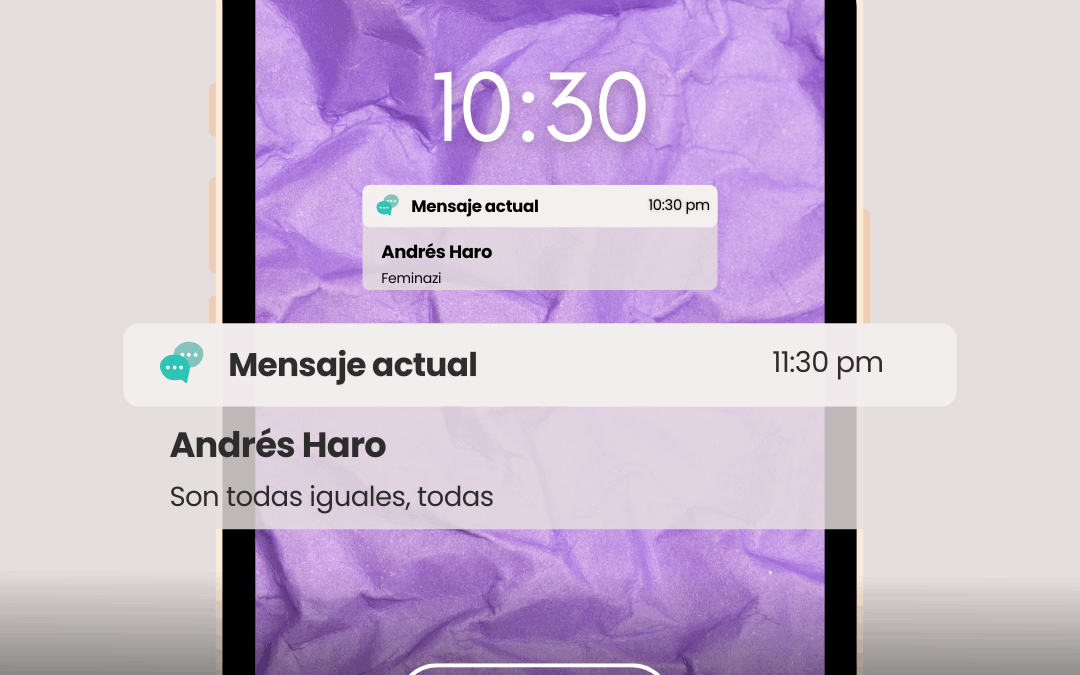

En el mundo del trabajo, del empleo, esto tiene consecuencias muy concretas. Cada vez más empresas utilizan algoritmos para tomar decisiones sobre contratación, asignación de tareas o evaluación del rendimiento. Si estos sistemas no están diseñados con una perspectiva de género, pueden penalizar a las mujeres, por ejemplo, por interrupciones en su carrera relacionadas con la maternidad o el cuidado de familiares. También pueden imponer un control rígido y deshumanizado sobre las personas trabajadoras, dificultando la flexibilidad y fomentando formas de empleo más precarias, algo que suele afectar más a las mujeres por ser ellas quienes, en la mayoría de los casos, asumen más responsabilidades domésticas y de cuidado.

Para evitar que la inteligencia artificial se convierta en un motor de desigualdad, es importante que quienes la diseñan y utilizan sigan principios claros. La transparencia significa que podamos entender cómo funciona un sistema, de dónde salen sus datos y por qué toma ciertas decisiones. La rendición de cuentas asegura que, si un algoritmo comete un error o discrimina, haya responsables que puedan responder y corregirlo. Y la no discriminación implica aplicar medidas para que las decisiones de la IA no favorezcan ni perjudiquen a nadie por su género, origen o cualquier otra condición. Países como Suecia ya aplican esta perspectiva en la práctica, con proyectos que mejoran la salud de las mujeres, fomentan su acceso a la educación tecnológica, impulsan la igualdad económica o ayudan a prevenir la violencia machista.

Esto implica, por ejemplo, contar con equipos diversos en el desarrollo de la IA para aportar diferentes puntos de vista y detectar posibles problemas desde el inicio, revisar de forma periódica los datos y algoritmos para eliminar sesgos antes de que causen daño, y aprovechar la IA para reducir desigualdades, como por ejemplo, creando sistemas que detecten brechas salariales o herramientas de ayuda rápida para víctimas de violencia de género.

También es esencial reducir la brecha digital, facilitando el acceso a la tecnología y la formación en competencias digitales a mujeres y niñas, para que puedan participar plenamente en la sociedad digital. La inteligencia artificial, por sí sola, no es justa ni injusta; somos las personas quienes, con nuestras decisiones, determinamos si esta tecnología repetirá las desigualdades del pasado o contribuirá a construir un futuro más igualitario.

Desde una mirada feminista e interseccional, la inteligencia artificial no es sólo tecnología, sino un reflejo de las prioridades, valores y estructuras de poder de la sociedad que la crea.

Si su desarrollo sigue dominado por un grupo reducido, mayoritariamente hombres, blancos y de entornos privilegiados, la IA seguirá proyectando sólo una parte muy limitada de la realidad y dejará fuera las voces, necesidades y experiencias de una gran parte de la población. Esto no es un simple fallo técnico, sino el resultado de decisiones sobre quién participa, qué datos se recopilan y qué problemas se consideran importantes. Por ello, entendemos que no basta con “ampliar más diversidad” a posterior, sino que es necesario repensar desde el inicio quién está en la mesa cuando se diseñan los sistemas, cómo se evalúan los datos y qué impacto real tendrán en la vida de las personas. Apostar por una IA con perspectiva de género no es un añadido opcional, es una condición para que la tecnología sirva de forma justa y eficaz a toda la ciudadanía. Significa construir cada algoritmo, cada análisis y cada herramienta con la conciencia de que la neutralidad no existe, porque o reproducimos los privilegios del pasado o transformamos la forma en la que decidimos y actuamos para que el futuro digital sea verdaderamente inclusivo e igualitario.